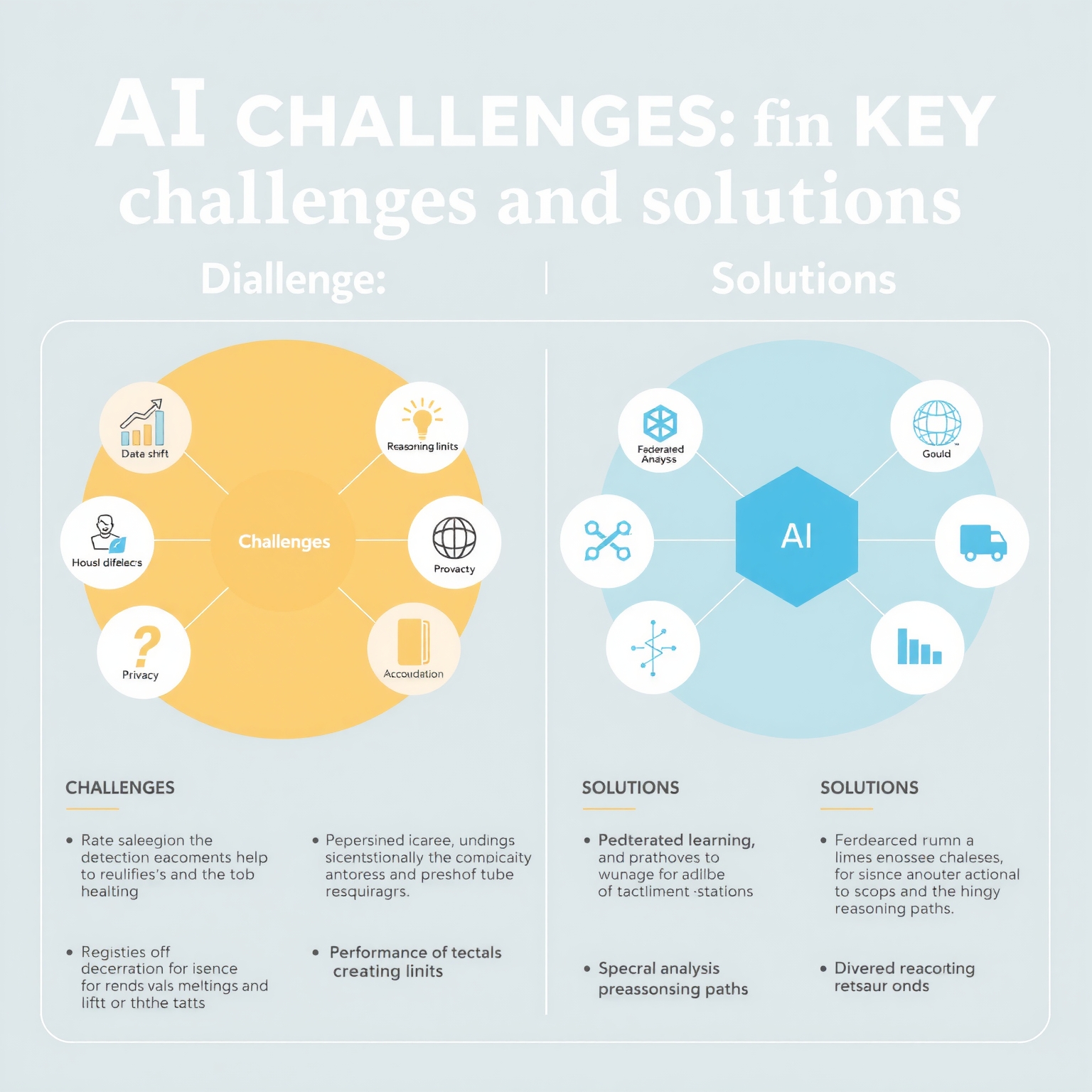

L'intelligence artificielle, et particulièrement les grands modèles de langage (LLM) et les modèles vision-langage (VLM), promet de révolutionner de nombreux secteurs, de la médecine à la finance. Cependant, la transition entre un environnement de développement contrôlé et le monde réel révèle des défis majeurs. Comment garantir que ces systèmes sophistiqués maintiennent leur performance face à des données imprévues, protègent la vie privée et stimulent l'innovation, plutôt que de simplement reproduire ce qui existe déjà ?

Les avancées récentes en matière de détection de dégradation de performance, d'analyse du raisonnement et d'optimisation sécurisée dessinent les contours d'une IA plus robuste, fiable et potentiellement plus créative. Ces recherches sont essentielles pour bâtir la confiance et étendre les capacités de l'intelligence artificielle dans des applications critiques et complexes, où l'erreur n'est pas une option.

Fiabilité et robustesse : les défis de l'IA en "milieu hostile"

L'un des enjeux majeurs de l'IA est sa capacité à rester performante une fois déployée. Dans des domaines sensibles comme l'imagerie médicale, la détection de la dégradation des performances est vitale. Selon une étude récente de Hao Guan et Li Zhou, publiée sur arXiv, les modèles vision-langage (VLM) utilisés en pathologie peuvent voir leur efficacité diminuer lorsque la distribution des données d'entrée change par rapport à celles utilisées lors de leur entraînement (le "data shift"). La détection de cette dégradation est complexe, surtout sans étiquetage manuel des nouvelles données, mais elle est essentielle pour la fiabilité clinique de ces outils prometteurs (Source 1).

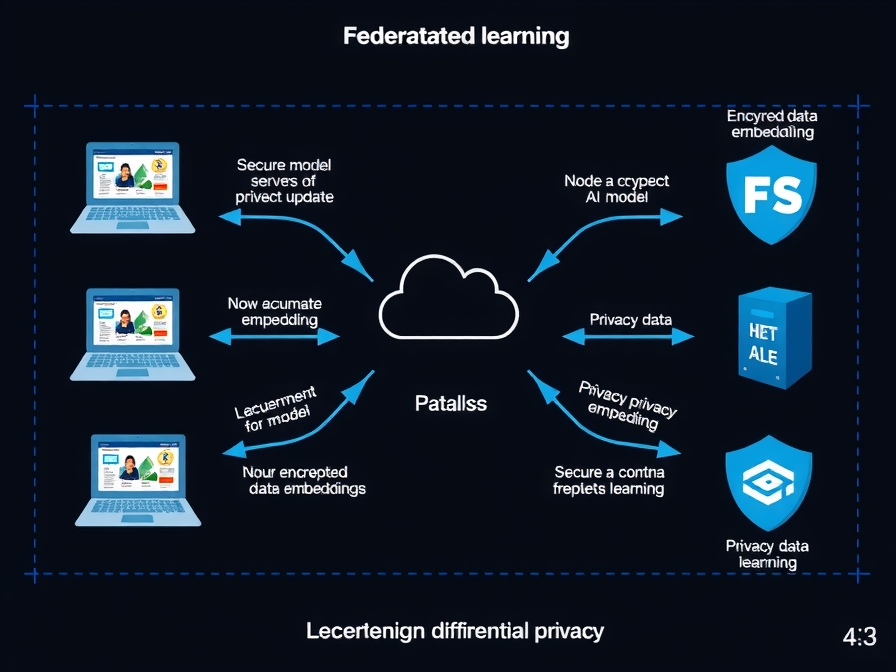

Parallèlement, le partage de données pour améliorer les modèles d'IA soulève d'importantes questions de confidentialité. L'apprentissage fédéré offre une solution en permettant aux modèles d'apprendre de données décentralisées sans centraliser les informations brutes. Cependant, les méthodes existantes peinent avec l'hétérogénéité des données entre clients et offrent une protection limitée contre les fuites d'informations sensibles. Pour y remédier, Sunny Gupta et Amit Sethi proposent FedHypeVAE, un cadre qui utilise des hyperréseaux pour générer des données d'intégration conditionnelles de manière différentiellement privée, renforçant ainsi la protection des informations sensibles tout en permettant une collaboration efficace (Source 3).

Décrypter l'intelligence : raisonnement, créativité et optimisation

Au-delà de la simple performance, comprendre comment les modèles d'IA raisonnent est une quête fondamentale. Valentin Noël, dans une recherche intitulée "Geometry of Reason", explore une méthode sans entraînement pour détecter la validité du raisonnement mathématique dans les grands modèles de langage. En analysant les matrices d'attention comme des graphes dynamiques, il extrait des diagnostics spectraux tels que la valeur de Fiedler ou l'énergie haute fréquence, offrant une nouvelle perspective sur la "géométrie de la raison" de l'IA (Source 2). Cette approche pourrait permettre de mieux évaluer et potentiellement améliorer la logique interne des LLM.

Cependant, un dilemme se profile : la recherche de la justesse peut parfois étouffer la créativité. Max Ruiz Luyten et Mihaela van der Schaar mettent en lumière un "compromis raisonnement-créativité" dans les pipelines de LLM. Les méthodes actuelles, qui privilégient les chaînes de pensée les mieux notées pour optimiser la correction, peuvent réduire l'entropie sémantique et freiner la résolution créative de problèmes. Leur travail souligne l'importance de préserver la diversité des chemins de raisonnement pour favoriser l'émergence de solutions innovantes (Source 5).

Ces capacités de raisonnement et d'optimisation trouvent des applications concrètes, notamment en finance. Simon Paquette-Greenbaum et Jiangbo Yu explorent l'utilisation d'agents LLM pour l'optimisation de portefeuilles d'investissement. Le problème de l'optimisation de portefeuille moyenne-variance avec contrainte de cardinalité (CCPO) est notoirement difficile à résoudre avec les méthodes exactes. Les agents LLM pourraient offrir des solutions plus efficaces pour naviguer dans la complexité des marchés financiers et identifier des frontières efficientes (Source 4).

Implications et perspectives

Ces recherches récentes soulignent une transformation profonde dans le développement de l'intelligence artificielle. Nous passons d'une ère où l'accent était mis sur la capacité brute de l'IA à apprendre, à une ère où la fiabilité, la robustesse, la transparence du raisonnement et la stimulation de la créativité deviennent primordiales. Les avancées dans la détection du "data shift" et l'apprentissage fédéré différentiellement privé sont cruciales pour déployer l'IA dans des environnements sensibles comme la santé, garantissant à la fois la performance et la protection des données. L'exploration de la "géométrie de la raison" et l'analyse du compromis raisonnement-créativité ouvrent la voie à des modèles de langage plus sophistiqués, capables non seulement de résoudre des problèmes complexes mais aussi d'innover. L'application des agents LLM à des tâches d'optimisation financière n'est qu'un exemple des vastes possibilités qui s'offrent lorsque ces systèmes deviennent plus fiables et intelligents. L'avenir de l'IA réside dans sa capacité à être à la fois puissante, éthique et véritablement ingénieuse.

Faits marquants

- Les modèles d'IA médicaux (VLM) sont vulnérables à la dégradation de performance due aux changements de données ("data shift") après déploiement, nécessitant des méthodes de détection innovantes (Source 1).

- FedHypeVAE propose une méthode d'apprentissage fédéré sécurisée par la confidentialité différentielle pour partager des intégrations de données sans centraliser les informations brutes (Source 3).

- Une nouvelle approche basée sur l'analyse spectrale des matrices d'attention peut détecter la validité du raisonnement mathématique dans les grands modèles de langage (Source 2).

- Les pipelines actuels des LLM peuvent sacrifier la créativité au profit de la justesse, nécessitant des stratégies pour préserver la diversité des chemins de pensée (Source 5).

- Les agents basés sur les LLM montrent un potentiel prometteur pour résoudre des problèmes d'optimisation complexes, comme l'optimisation de portefeuilles d'investissement (Source 4).

Sources et références

- Detecting Performance Degradation under Data Shift in Pathology Vision-Language Model (2026-01-02)

- Geometry of Reason: Spectral Signatures of Valid Mathematical Reasoning (2026-01-02)

- FedHypeVAE: Federated Learning with Hypernetwork Generated Conditional VAEs for Differentially Private Embedding Sharing (2026-01-02)

- LLM Agents for Combinatorial Efficient Frontiers: Investment Portfolio Optimization (2026-01-02)

- The Reasoning-Creativity Trade-off: Toward Creativity-Driven Problem Solving (2026-01-02)